はじめに

このブログの主要トピックであるAI、その歴史をここで改めて振り返ってみたいと思います。

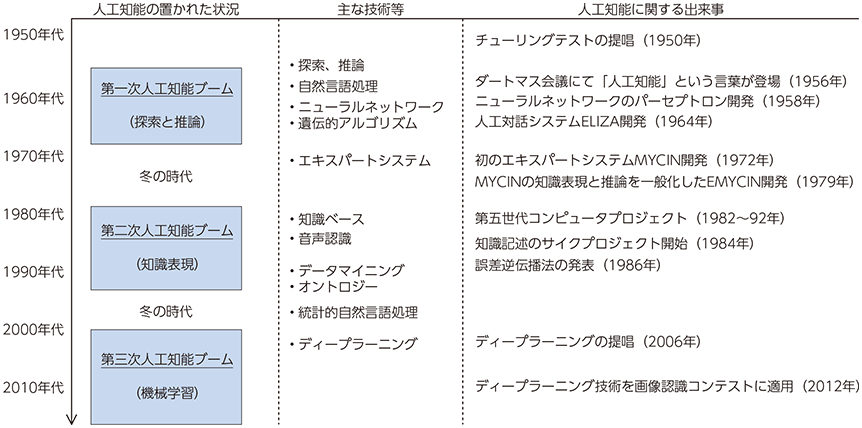

AIの歴史は思ったより浅く、AI=人工知能の概念が誕生したのは1950年代(今から70年前)です。

AIの概念の誕生:1950年代

ここでは、AIの基礎となる理論や概念が提唱されました。1950年には、イギリスの数学者アラン・チューリングが、コンピュータが人間と同じように考えることができるかどうかを判定する「チューリングテスト」を提案しました。

1956年には、アメリカのマサチューセッツ工科大学(MIT)で「ダートマス会議」と呼ばれるAIの研究会が開催され、ジョン・マッカーシー、マーヴィン・ミンスキー、クロード・シャノンらは、人工知能を研究するための道筋を検討しました。ダートマス大学で数学の教授であったジョン・マッカーシーが「人間のように考える機械」を「人工知能(Artificial Intelligence)」と名付けました。

第1次AIブーム:1960~1974年

1960年代には、「推論」や「探索」と呼ばれる技術により、パズルや簡単なゲームなど、AIは明確なルールが存在する問題に対して高い性能を発揮し、人工知能に大きな期待がかけられました。

・推論:人間の思考過程を、記号で表現し実行しようとすること

・探索:目的となる条件(答え)を、解き方のパターンを場合分けして探し出すこと

特に、1966年にマサチューセッツ工科大学のジョセフ・ワイゼンバウムにより開発された初の自然言語処理プログラム、イライザ(ELIZA)は特に有名です。イライザはチャットボットの元祖とも言われています。

冬の時代①:1974~1980年

AIの研究に対する期待と現実のギャップが大きくなり、AIの研究に懐疑的な考えが広がり始めました。この時期には、AIの限界や技術的な困難さが明らかになりました。例えば、自然言語処理や画像認識などのタスクは、人間にとっては簡単でもコンピュータにとっては難しいことが分かりました。また、コンピュータの性能やメモリ容量もAIの発展に足かせとなり、AIブームは下火となり、研究支援が滞り、AIの開発は失速します。

第2次AIブーム:1980~1987年

第2次AIブームは、エキスパートシステムの実現によりAIの研究が活発化したことで起こりました。

エキスパートシステムとは、専門分野の知識をコンピュータに記述し、推論することで、その分野の専門家のように振る舞うプログラムです。このようなシステムは、医療、法律、金融などの分野で実用化されました。

エキスパートシステムの開発自体は1960年代から行われており、AIの研究者たちは冬の時代においても精力的に研究を進めていました。この頃には、多くの大企業がエキスパートシステムを業務に導入するなど、実用的なツールとして広く商用利用されるようになりました。

また日本では、政府による「第五世代コンピュータ」と名付けられた大型プロジェクトが推進されましたが、当時はコンピューターが必要な情報を自ら収集して蓄積することはできなかったため、必要となる全ての情報について、人がコンピューターにとって理解可能なように内容を記述する必要がありました。

世にある膨大な情報全てを、コンピューターが理解できるように記述して用意することは困難なため、実際には特定の領域での使用に限定するなど、これらの問題から、1990年代に入ると再び冬の時代を迎えることになりました。

冬の時代②:1987~1993年

研究を重ねる中で、次第にエキスパートシステムにも限界があることがわかると、1987年から1993年まで2回目の冬の時代を迎えるようになります。

当時のAIは、人が手動で膨大な知識をコンピュータに記述する必要があり、またそこまでやっても、例外処理や矛盾したルールには対応できないという限界がありました。

第3次AIブーム:2000年代~

第3次AIブームの開始は諸説ありますが、2000年代からと見る向きが一般的です。その中でも顕著なのが、ディープラーニングが登場した2006年以降です。それまでも1997年にチェス専用のコンピューター ディープブルーがチェス世界王者に勝利し、AIが人間に初めて勝利した瞬間として、非常に大きなニュースとして取り上げられました。

この第3次AIブームの原動力になっている技術革新は2つあります。

技術革新①:機械学習の実用化

AIの限界の一つであった、コンピュータが自ら情報を収集して蓄積できないという問題は、機械学習の実装によって解決されました。機械学習とは、コンピュータが自動で自ら大量のデータから学習し、分類や予測などのタスクを遂行するアルゴリズムやモデルを構築する技術です。

これにより、「ビッグデータ」と呼ばれる膨大なデータ群をAI自身が収集し知識を獲得することができるようになりました。ビッグデータとは、従来のデータベース管理システムなどでは記録や保管、解析が難しいような大量のデータ群のことです。

技術革新②:ディープラーニングの登場

ディープラーニング(深層学習)とは、対象の全体像から細部までの各々の粒度の概念を階層構造として関連させて学習する機械学習手法の一手法です。それまでは、技術的な問題により十分な学習をさせられず、性能も芳しくありませんでしたが、2006年にジェフリー・ヒントンの研究チームが多層ニューラルネットワークによる学習手法を見出し、学習に必要な計算機の能力向上とインターネットの発展による学習データの流通と相まって、従来をはるかに超える学習量を持たせられるようになりました。その結果、人間が行うタスクをコンピューターに覚えさせることができるようになり、音声・画像・自然言語を対象とするインプットに対して高い精度の解決能力を示しました。

ディープラーニングは、従来の機械学習と比べて、人間が特徴量を定義する必要がありません。ディープラーニングは、学習データからコンピュータが自動で特徴量を抽出し、精度を向上させることが可能です。ここで特徴量とは、学習の入力に使う測定可能な特性のことです。例えば、赤いリンゴと青いリンゴを識別する際には「色」が特徴量となります。人は、モノを識別する際に無意識に適切な特徴量を利用しますが、これまでのコンピュータは識別に利用すべき特徴量を自ら定義できず人間が入力しており、これがAIの技術的障壁でした。ディープラーニングによって、「人の顔の識別」などの複雑な問題でもAI自らが適切な特徴量を捉えることができるようになりました。

この深層学習が機械学習分野に与えた影響は非常に大きく、2015年に発表された拡散モデルに代表される生成モデルの多くに組み込まれたほか、2017年に発表されたTransformerをはじめとする大規模言語モデルなどの基盤にもなっています。しかし、深層学習によって行われたパターン認識がどのような根拠に基づいて行われているかを解析することは難しく、ブラックボックス化していることが問題となっています。

このように、「AI自身が知識を獲得する」「AIが自ら特徴量を獲得する」ことができるようになったことは人工知能の研究分野におけるブレークスルーとなり、現在の人工知能研究のブームの起爆剤となりました。

新しいAIの時代

では、これからのAIの進化はどのような未来を描いていくのでしょうか。

レイ・カーツワイル博士は、「2029年にAIが人間並みの知能を備え、2045年に技術的特異点が来る」と提唱しています。この問題は2045年問題とよばれます。

”技術的特異点”とは”シンギュラリティ”とも言われており、AIなどの技術が自らによって人間より賢い知能を生み出す事が可能になる時点のことを言います。米国の数学者ヴァーナー・ヴィンジにより最初に広められ、人工知能研究の権威であるレイ・カーツワイル博士も提唱する概念です。

シンギュラリティは私たちの雇用に大きく変化を及ぼすと考えられています。今人間が担当している業務の一部、あるいはほとんどをAIが代わりに担うようになる未来はそう遠くないと思われるからです。私たちの働き方は今から10年後、20年後には著しく変化している可能性があります。

現に、インターネットが普及した時もそれまでの色々な職業がなくなり、また新しい職業ができました。

まとめ

AIが誕生してから今日までの70年あまりの歴史の中で、私たちの暮らしはAIと共に変化を遂げてきました。そしてこれから訪れるであろうシンギュラリティも、今の私たちの暮らしを大きく変化させる可能性を持っています。

驚くべきスピードで進化するAIに後れを取ることなく、私たちも新しい時代に順応していかなければなりません。

私は今のAIの独学を通してAIと協調して未来を創っていきます。

AIと共に未来を創る!

コメント